Le métrologue doit être au pied des machines !

Industrie 4.0, objets connectés, nouvelles versions des normes ISO 9001 et 17025… , des évolutions majeures se mettent progressivement en place dans les entreprises qui deviennent ainsi de plus en plus agiles et réactives. Il est temps désormais que ce renouveau se diffuse également à la métrologie. Au-delà de son rôle de respect de la conformité aux référentiels normatifs applicables et de justification de la traçabilité aux étalons nationaux afin de garantir la satisfaction de l’auditeur, la Smart Metrology doit recentrer son énergie sur l’essentiel : la qualité des mesures produites dans l’entreprise !

Un peu d’histoire de la qualité

L’obsession de l’ISO 9001, ou de tout autre certification, de tout uniformiser et catégoriser, a fait perdre de vue le rôle de certaines fonctions au sein de l’entreprise. Par le passé, il n’était pas rare de rencontrer des responsables Qualité concentrés uniquement sur leurs procédures et autres fiches de poste en oubliant parfois leur fonction légitime, c’est à dire satisfaire les clients de l’entreprise. En caricaturant un peu, certains étaient surtout sensibles aux exigences de l’auditeur et leurs efforts portaient plus sur la tenue à jour des indicateurs que sur leur amélioration objective. Je me régale souvent à raconter que dans une entreprise que j’ai bien connue, les hommes « Qualité » m’expliquaient que « faire la qualité leur prenait un jour par semaine » alors que la qualité aurait dû les occuper à chaque instant. Ils faisaient « la Qualité » (pour leurs auditeurs) plutôt que faire « de la Qualité » (pour leurs clients). Un autre encore était plus préoccupé, en arrivant en poste dans une PME dont les équipes connaissaient parfaitement leur travail dans un domaine qu’il n’avait lui-même jamais fréquenté, à rédiger des fiches de postes plutôt que d’aller sur le terrain rencontrer les clients (externes ou internes : services R&D, production, opérateurs, …) et identifier leurs attentes et leur niveau de satisfaction …De nos jours, l’ISO 9001, conscient de ces excès, évolue et une nouvelle génération de qualiticiens tente de rendre à la qualité tout son intérêt pour l’entreprise.

La Smart Metrology : un véritable outil d’aide à la décision

Les mesures dans l’entreprise sont souvent considérées comme des « go/no go ». On mesure pour décider « sur le champ », en général soit pour accepter un lot ou pour accepter un réglage afin de lancer une série. La mesure elle-même, une fois la décision prise, n’intéresse plus … Dans le cas de la gestion des instruments, combien d’entreprises se contentent par exemple d’un constat de vérification (Bon / Pas bon) sans aller chercher plus loin ? Si l’enregistrement de l’avis et de la date permet effectivement de valider une utilisation/production passée et de calculer la prochaine date, il ne permet rien de plus et c’est bien là le problème !

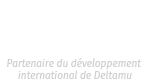

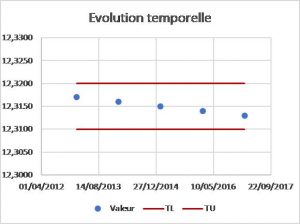

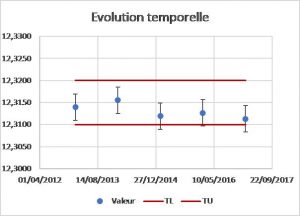

Lorsque des données sont disponibles

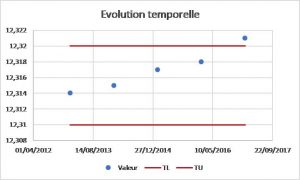

Lorsque seuls les avis sont disponibles

Dans les deux cas ci-dessus, le lecteur remarquera qu’avec des données, on aurait pu éventuellement prévenir la non-conformité qui se dessinait. Avec le seul « avis », rien ne permettait de voir arriver ce problème.

Remarque importante : Certaines méthodes d’optimisation proposent d’augmenter la périodicité quand l’avis est « conforme » plusieurs fois de suite, ce qui revient donc à accélérer alors qu’on sait que le mur est devant nous (puisque la non-conformité finira par arriver à un moment ou à un autre …)

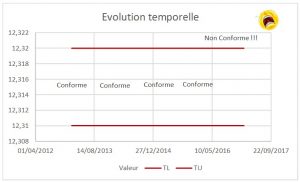

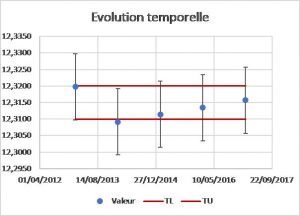

Néanmoins, les données ne permettent pas toujours de prévoir ce qui va se passer (figure ci-dessous). Si, contrairement au cas ci-dessus, les données montrent une variabilité importante du phénomène, la prédiction ne peut pas se faire. En revanche, elles alertent sur l’instabilité, donc sur le risque. Les stratégies de maîtrise sont alors très différentes du cas simple d’une dérive monotone.

L’exploitation des données, lorsqu’elles sont disponibles, permet d’observer des événements et, bien souvent, de comprendre des phénomènes qui seraient restés inconnus si aucune valeur n’était disponible. Les entreprises payent cher les mesures qu’elles produisent. Aux temps passés à faire (c’est à dire « produire » !) les mesures sur le terrain s’ajoutent les investissements en matériels, en personnels et en suivi (dans le cadre des certifications notamment). Toute cette « richesse » s’évapore souvent, et malheureusement, dans de simples avis ! Il est plus que temps désormais que les industriels se rendent compte de toute cette valeur potentielle perdue, les illustrations précédentes le montrent !

L’incertitude de mesure à l’ère du Big Data

Cette question de la valeur des données est au cœur de l’évolution « Big Data » dans l’Entreprise du Futur. En effet, stocker des données ne suffit pas, il est impératif que celles-ci soient fiables (4ème V du Big Data : la véracité) ! La croyance en des valeurs mesurées « justes » reste persistante malgré trente années de certification qui aurait pourtant du familiariser les industriels sur la nature aléatoire d’un résultat de mesure. Les mesures ne sont pas justes et il faut donc se soumettre à cette réalité pour espérer en tirer profit. Ainsi, et pour analyser objectivement des données, l’incertitude associée s’impose comme une nécessité absolue.

A titre pédagogique, et pour mettre en évidence l’impact des incertitudes de mesure dans l’analyse, nous pouvons simuler des données mesurées à partir d’un phénomène réel que nous choisirons arbitrairement linéaire (cas simple).

Cas simple : Phénomène réel linéaire

Suivant que le processus de mesure qui sera mis en place pour observer le phénomène ci-dessus, les valeurs obtenues, entachées d’erreurs, peuvent montrer des choses apparemment très différentes.

Dans le cas où l’incertitude de mesure est petite, les mesures décrivent « à peu près » la réalité :

Valeurs mesurées du phénomène avec une incertitude faible

En revanche, lorsque l’incertitude de mesure est plus importante, les observations ne permettent pas de « deviner » la réalité :

Valeurs mesurées du phénomène avec une incertitude importante

Dans le monde actuel, monde dans lequel les mesures servent à prendre des décisions à partir de tolérances décrivant apparemment le besoin, les incertitudes ne sont pas toujours connues explicitement. En fait, elles ont souvent déjà été prises en compte dans les tolérances exprimées, de façon souvent implicite. Les faits sont là : en mesurant dans les tolérances demandées, et sans tenir compte des incertitudes, la décision est pertinente car l’entité assure finalement sa fonction. Cela ne signifie pas que l’entité respecte, dans sa réalité, la tolérance, mais qu’en la mesurant dans la tolérance, et malgré l’incertitude non prise en compte, la fonctionnalité est assurée. Les tolérances sont donc généralement bien plus serrées que le besoin réel. Ce simple constat permet d’envisager un avenir à la fonction Métrologie : Mieux comprendre les phénomènes en garantissant une incertitude adéquate pour pouvoir exprimer le juste besoin, et non pas se prémunir arbitrairement d’une erreur de mesure mal (ou non) évaluée. Cette stratégie, dite « au pire des cas », est contre-productive car très coûteuse, nous n’en avons plus les moyens !

La fiabilité des mesures au service de la productivité

Une fois ces grands principes simples intégrés, le métrologue dans l’entreprise peut comprendre sa vraie mission. Il ne s’agit pas de faire plaisir à l’auditeur en lui servant ce qu’il a l’habitude de voir mais bel et bien de permettre à son entreprise de comprendre ses procédés de fabrication (et plus généralement les phénomènes qui l’impactent) de façon à les piloter de façon efficiente. Pour cela, il doit être le garant de la fiabilité des mesures, en tous cas connaître et maîtriser l’incertitude de mesure qui « pollue » les données et qui peuvent « tromper » l’analyste quant aux conclusions qu’il remettra.

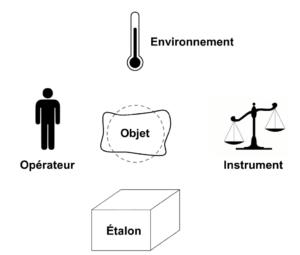

Synoptique d’un processus de mesure

La mesure relève d’un processus, comme toute production humaine. Ce processus met en jeu différents facteurs qu’il convient de maîtriser pour maîtriser la totalité du processus. Ainsi, et après avoir passé de longues années à s’intéresser quasiment exclusivement à l’un d’entre eux (l’instrument, à l’instar de la métrologie légale qui ne nourrit pas les mêmes objectifs que la métrologie industrielle), le métrologue doit désormais prendre en compte tous les autres, et notamment l’opérateur. Pour ce dernier, le rôle du métrologue est au pied des machines. Il doit accompagner l’opérateur dans sa production de mesures. Un bon instrument est une condition nécessaire, mais pas suffisante. L’opérateur a en général l’intuition « métier » d’une mesure fiable et opérationnelle, puisqu’il effectue l’opération régulièrement. Le métrologue doit lui apporter sa compétence par une formalisation et une quantification de cette intuition. C’est le rôle transverse de la métrologie. Elle permet de mieux comprendre certains phénomènes, de motiver des améliorations, de justifier des décisions pour l’ensemble des services de l’entreprise dans lesquels intervient la mesure.

Big Data et Industrie 4.0

L’avenir est à l’exploitation des données : les GAFA (Google, Amazon, Facebook, Apple) ont démontré qu’il était possible d’extraire des données dont ils disposent énormément d’informations valorisables. Ils se sont aussi rapidement rendus compte que cette « valeur » imposait la véracité desdites données. Dans le monde industriel, cette véracité équivaut à l’incertitude, et l’incertitude ne vient pas uniquement de l’instrument, mais de tout le processus. Dès lors, le métrologue a une chance historique en comprenant ces nouveaux enjeux et en mettant en œuvre une fonction Métrologie révisée, orientée fiabilité plutôt que simplement conformité (aux exigences de l’auditeur).

Tout comme l’exemple précédent (Une simple dérive temporelle), le Big Data impose de disposer de données représentatives (c’est à dire fiables) pour tenter de comprendre la réalité (souvent plus complexe, car multidimensionnelle. Lire La quête du “Graal” se tiendra dans l’hyperespace). Ce Big Data avance à grands pas dans les entreprises conscientes de ces nouvelles possibilités (stockage et analyse de données massives) mais les analyses ne donneront des résultats probants que si les données sont fiables. Des données sont produites tous les jours et plus vite le métrologue se saisira de cette mission, au plus proche du terrain, plus il sera prêt à devenir un acteur utile du Big Data.

Personnellement, je ne m’imaginerais pas une seconde devoir justifier devant ma direction que tous les coûts engagés dans la fonction Métrologie depuis la certification (30 ans) n’ont pas permis de garantir des mesures exploitables. Imaginez un moment qu’il faille repartir à zéro, tandis que nos concurrents, eux, disposent de données fiables …