G.U.M. : Il y a peut-être un hic…

This article is also available in english.

Le calcul d’incertitude, même s’il n’est pas encore tout à fait entré dans les mœurs de tous les industriels, occupe de plus en plus de métrologues à travers le monde. Pour les aider dans cette tâche, le J.C.G.M. WG 1 a publié en 1995 le document J.C.G.M. 100, plus connu sous le nom de G.U.M. (Guide to the expression of uncertainty in measurement). Ce document est repris depuis longtemps dans la collection des normes ISO. Il est publié par l’AFNOR sous sa nouvelle référence NF ISO/CEI GUIDE 98-3 depuis juillet 2014.

Le G.U.M. propose une approche probabiliste de l’incertitude de mesure. Il s’intéresse essentiellement aux effets aléatoires qui entachent d’un inexorable doute tout résultat de mesure. Dans l’esprit du G.U.M. en effet, les effets systématiques, qui n’y sont pas vraiment traités, doivent être corrigés, et personne ne pourra s’opposer à cette vision. N’est-ce pas là d’ailleurs l’un des rôles dévolus à la métrologie ?

Avant d’aller plus loin et de s’interroger sur l’éventuel « hic » dans le G.U.M., il convient de se rappeler ce qu’est un phénomène aléatoire. Pour cela, l’exemple du lancer de dés est probablement l’un des plus pédagogiques.

Lorsque nous lançons trois dés, nous ne savons pas dire, a priori, quelle valeur la somme de leurs faces produira car cette somme est aléatoire. À chaque lancer, elle peut prendre des valeurs différentes, ce qui ne permet pas de la prédire. Les statisticiens ne peuvent finalement que nous informer que sur la probabilité que telle ou telle valeur apparaisse. Si nous lançons 1 dé par exemple, la probabilité de faire 1, 2, 3, 4, 5 ou 6 est de 1/6 (cas d’un dé non pipé). Les statisticiens ont d’ailleurs pu démontrer que sous certaines conditions souvent respectées, la probabilité d’apparition des valeurs possibles d’un phénomène complexe (c’est-à-dire qui trouve son origine dans les effets de plusieurs phénomènes élémentaires eux-mêmes aléatoires) suit une loi dite « loi normale ». Ladite loi normale est totalement définie par deux paramètres : sa moyenne et son écart type. Ainsi, en connaissant seulement deux paramètres, il est possible de définir la probabilité de n’importe laquelle des valeurs que le phénomène aléatoire peut produire.

Note : en métrologie, ce type de phénomène aléatoire (mais pas forcément gaussien) est typique. Par exemple, il en va ainsi très souvent de l’ambiance climatique d’un milieu de mesure. En entrant dans une pièce, on ne sait pas quelle température exacte il fait mais on peut définir la distribution, donc la probabilité, de chaque valeur envisageable…

De plus, les statisticiens ont démontré que la variance d’un phénomène aléatoire complexe est égale à la somme des variances des phénomènes élémentaires qui le composent (sous réserve que les phénomènes élémentaires soient indépendants). Le G.U.M. repose sur cette propriété d’additivité des variances. L’évaluation de l’incertitude de mesure d’un processus repose donc sur l’inventaire des phénomènes élémentaires, l’évaluation de leur variance respective (par des méthodes de type A – expérimentales – ou de type B – documentaires) pour les additionner. Évidemment, il faut également tenir compte du modèle de mesure qui peut introduire des coefficients de sensibilité différents de 1 pour chaque phénomène élémentaire.

Ainsi, et pour conclure sur ce rappel, un phénomène est dit « aléatoire » lorsqu’il varie, c’est-à-dire lorsque nous ne pouvons pas prédire la valeur qu’il prendra lors d’une observation donnée. La dispersion d’un tel phénomène aléatoire est quantifiée par un objet mathématique appelé « écart type » et les carrés des écarts types des phénomènes élémentaires aléatoires s’ajoutent pour donner la variance globale du phénomène d’intérêt.

Lors de l’évaluation de l’incertitude de mesure d’un processus donné, il est d’usage de considérer l’incertitude d’étalonnage comme l’une des causes d’incertitude participant à l’incertitude globale. Elle est alors considérée comme l’un des phénomènes élémentaires aléatoires qui entachent la qualité de la mesure…

Or, l’incertitude d’étalonnage provient de l’imperfection de la mesure au moment de l’étalonnage, c’est un fait ! Elle n’entache pas la réalité de l’objet étalonné mais seulement la connaissance que nous en avons ! Dans le cas de masses étalons par exemple, les masses sont, en réalité, ce qu’elles sont et l’erreur produite au moment de leur étalonnage n’y change rien… L’incertitude d’étalonnage est donc l’expression de l’imperfection de l’étalonneur, pas de celle de la masse elle-même ! Si l’incertitude d’étalonnage a un caractère indubitablement aléatoire, la valeur « vraie » de la masse étalonnée, en un temps donné, n’a rien d’aléatoire. Elle est ce qu’elle est, même si nous ne saurons jamais ce qu’elle est réellement !

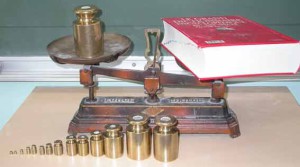

Analysons ensemble le processus de mesure ci-dessus photographié. L’évaluation de la masse du livre impose de disposer de masses étalons permettant d’équilibrer la balance. Si l’équilibre n’est pas parfait, l’opérateur devra lire un écart entre les plateaux de gauche et de droite. Cet écart sera additionné à la valeur des masses d’équilibre pour déterminer la masse du livre. Comme les masses ne sont pas mesurées directement (seuls les poids des objets sont accessibles), il conviendra également de tenir compte, en étant puriste, des différences de poussée d’Archimède qui s’exercent entre les masses étalons (d’une masse volumique MV1) et le livre (d’une masse volumique MV2). La poussée d’Archimède étant égale, dans les deux cas, au poids (Masse x Accélération « g ») du volume de fluide déplacé (ici de l’air), la température, la pression et l’humidité relative devront également être prises en compte.

Je cherche encore en quoi l’incertitude d’étalonnage participe à ce processus de mesure… Je comprends évidemment que cette incertitude, qui s’est exprimée lors de l’étalonnage des masses, m’interdit de connaître la valeur vraie desdites masses. Néanmoins, l’erreur qui s’est produite au moment de l’étalonnage n’intervient en aucune manière au moment de la mesure de mon livre… Mes masses sont ce qu’elles sont, je ne connais pas leurs valeurs vraies mais elles n’ont rien d’aléatoires par elles-mêmes (leurs poids, en revanche, peut varier en fonction des conditions de la mesure, mais pas leurs masses). Ajouter un effet aléatoire (l’incertitude d’étalonnage) dans le bilan des causes d’incertitude sur la mesure de mon livre n’a dès lors aucun sens statistique ! C’est une forme d’astuce dont la pertinence est discutable car la somme des variances n’a de sens que pour des phénomènes aléatoires…

L’approche probabiliste montre dans ce cas ses limites. Si elle excelle indiscutablement à quantifier les phénomènes aléatoires, elle bute sur la prise en compte des effets systématiques dont on ne connaît pas la valeur réelle (contenue dans un intervalle), ce qui est le cas ici, comme dans tant d’autres situations. Puisque nous évoquons les masses, on peut aussi évoquer la question de la valeur du coefficient local d’accélération, noté traditionnellement « g ». En un lieu donné, elle est systématique. Quand on la mesure, on a, inexorablement, une incertitude. Pour autant, et dans un processus de mesure de force (ou de masse) en un lieu donné, la valeur de « g » n’est pas « probabiliste ». Là encore, elle est ce qu’elle est, seule sa réalité ne nous est pas accessible ! Il est très différent de considérer cette méconnaissance sous l’angle probabiliste (comme c’est le cas aujourd’hui, par « bricolage ») que sous son angle réel : une valeur déterministe (systématique), mais inconnue. Car tel est bien le cas pour « g » comme pour la valeur vraie des masses étalons, mais aussi comme dans beaucoup d’autres cas en métrologie.

L’incertitude d’étalonnage ne contribue pas directement, sous sa forme évidemment aléatoire (au moment de l’étalonnage, on peut espérer que le laboratoire corrige intelligemment les effets systématiques), dans le bilan des causes d’incertitude d’un processus. En revanche, elle induit un doute sur la valeur réelle d’une quantité (la masse ou « g » ou autre), doute qui se matérialise par un intervalle dans lequel nous pouvons déterminer que se trouve possiblement la grandeur d’intérêt (la masse, la valeur du « g » local ou autre)…

Si l’approche « probabiliste » ne résout pas cette question, l’approche « possibiliste » semble apporter une solution à cette situation fréquente en métrologie. L’approche « possibiliste » fait appel au concept des « variables floues ». Dans ce monde, différent du monde de l’aléa, des stratégies de calcul ont été élaborées pour « additionner » (lire « associer ») des intervalles de « possibilités », quand le monde probabiliste additionne des variances. Le but de ce premier billet sur ce sujet n’est pas de décrire les stratégies « possibilistes ». Il s’agit ici, dans un premier temps, d’alerter les métrologues sur cette question qui méritera, il me semble, d’être largement développée à l’avenir.

Une équipe italienne particulièrement dynamique, menée par Alessandro Ferrero et Simona Salicone de l’École Polytechnique de Milan, publie régulièrement sur cette approche passionnante de la possibilité. J’aurai l’honneur de présenter, avec eux, une conférence sur ce sujet dans le cadre du prochain congrès international de métrologie, en septembre 2015, à Paris. D’ici là, je reviendrai vers vous tous pour vous en dire un peu plus…

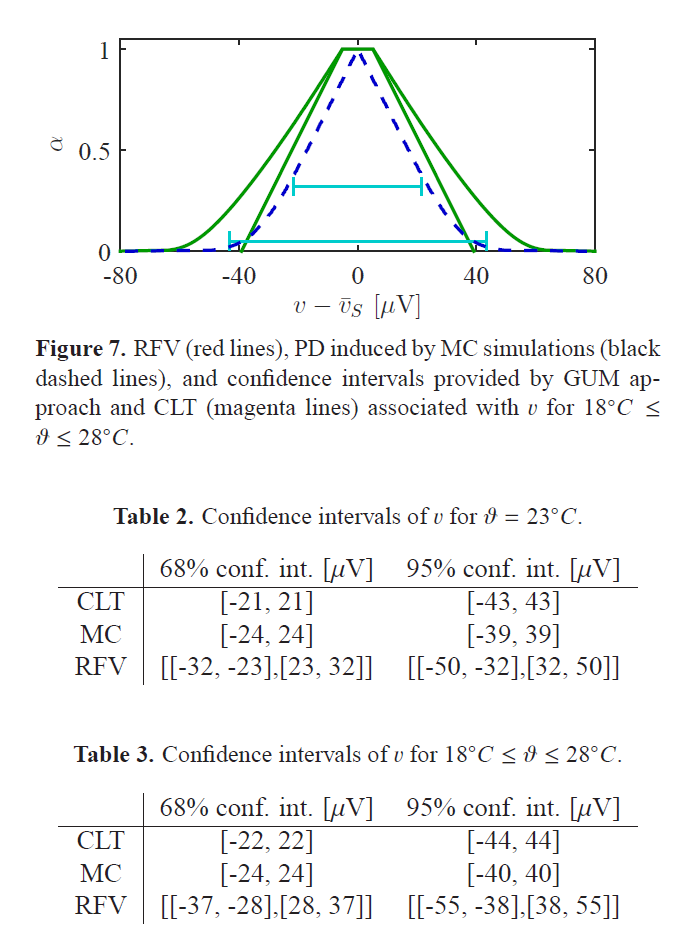

Néanmoins, je ne résiste pas au plaisir de vous montrer dès maintenant une figure « classique » du monde « possibiliste », histoire de commencer à vous habituer…