2019

| Un nouveau besoin pour les laboratoires accrédités : une base partagée des « a priori » |  |

Qu’est-ce que mesurer ?

La mesure est en quelque sorte consubstantielle à l’Homme. Depuis la nuit des temps, la mesure fait partie du quotidien de nos aïeux. Mesurer pour comprendre, comprendre les phénomènes physiques. Cette volonté nous a fait passer de peuplades le plus souvent polythéistes cherchant à expliquer leurs observations dans le monde physique, le plus souvent par l’action de divinités plus ou moins bienveillantes, à une civilisation technologique au cœur de laquelle la science a (pratiquement) fini par s’installer. Dans ce contexte, la mesure se présente comme un outil essentiel à la compréhension du monde. Sans mesures, le boson de Higgs reste dans la tête de Higgs, tout comme l’attraction newtonienne dans celle de Newton, l’électron chez Bohr et la relativité, restreinte ou générale chez Einstein.

Les temps ont bien changé depuis les sapiens chasseurs/ cueilleurs à l’homo-industrius « 4.0 » que nous sommes devenus au fil des siècles. Dans notre société désormais manufacturière et commerçante, la mesure sert à prendre des décisions. Des décisions sur la quantité réelle de marchandises échangées, quantité qui induit son prix, et des décisions sur les procédés industriels, décisions qui permettent de statuer sur la conformité des entités produites et, dans la négative, sur l’opportunité de réglages des procédés de production.

Il est d’usage, chez sapiens, de mettre « sous le tapis » les problèmes qu’il rencontre. Aussi, et pour simplifier des situations parfois complexes, une forme de consensus traditionnel s’est inscrite dans nos pratiques. Pour « décider », il faut le plus souvent « mesurer » et nous nous sommes accommodés, pour des raisons historiques sur lesquelles nous ne reviendrons pas ici (mais vous pouvez suivre le lien) à considérer que les mesures étaient justes, alors que nous savons bien sûr, nous les métrologues, que cela est techniquement impossible…

Cette réalité est tellement criante, en tout domaine, que dans son livre « Devenez sorciers, devenez savants », dont Henri Broch est co-auteur, Georges Charpak écrit : « … Or, il faut rappeler que l’incertitude sur une donnée est toute aussi importante que la donnée elle-même puisqu’elle décide de la fiabilité que l’on peut accorder à cette dernière et, par voie de conséquence, de la fiabilité à accorder à la théorie reposant sur ce résultat …». En interpellant ainsi ses pairs, Georges Charpak souligne que cette question de la fiabilité des mesures n’est pas forcément toujours au cœur des préoccupations des chercheurs.

Mesurer chez les industriels

Elle n’est pas non plus, preuve en est la pratique, au cœur des industriels. Le développement des certifications qualité type ISO 9001 depuis la fin du XXIème siècle le prouve aussi. La question des mesures se résume souvent à la conformité des instruments de mesure, conformité délivrée le plus souvent par des prestataires s’appuyant sur des normes, par définition généralistes, et non sur les besoins spécifiques de chaque utilisateur. Tout se passe donc comme si un instrument conforme produisait des mesures justes ce qui, dans un autre contexte, reviendrait à affirmer que si les plaquettes sont bonnes, la voiture freine bien.

Cette simplification des problèmes technologiques liés à la mesure nous a probablement conduit à faire beaucoup de bêtises, notamment en compensant notre manque de fiabilité des mesures par des exigences beaucoup plus sévères que fonctionnellement nécessaires. Le bon côté des choses, c’est qu’il reste beaucoup à faire pour optimiser nos pratiques, voilà un enjeu intéressant pour les nouvelles générations, enjeux cohérents avec les questions très actuelles de développement durable.

Le GUM (Guide pour l’Expression des Incertitudes de Mesure) a fait son apparition dans le monde de la métrologie en 1995. Depuis près de 25 ans, les métrologues bataillent pour comprendre ce GUM et le mettre en pratique. Il faut reconnaître qu’il n’est pas encore d’usage systématique dans le monde industriel, probablement pas non plus dans celui de la recherche sauf dans quelques domaines spécifiques. Pourtant, nous sommes nombreux à chercher à le maîtriser et à l’utiliser, notamment lorsqu’il s’agit de déclarer cette fameuse conformité évoquée ci-dessus. Si toutes les mesures sont fausses, toutes les décisions font naître le risque de se tromper. Et, puisque les erreurs de mesure n’ont en principe pas de préférence, il est possible de se tromper dans un sens, ou dans l’autre. Concrètement, on peut donc « déclarer conforme une entité non conforme en réalité » (Risque client) ou « déclarer non conforme une entité conforme en réalité » (Risque Fournisseur).

Le risque

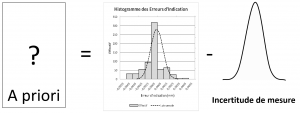

Cette question des risques Client et Fournisseur fait partie du quotidien du métrologue, mais un document récent, le JCGM N°106 devenu la norme ISO/IEC Guide 98-4, vient bousculer notre vision des choses. Dans le monde d’avant ce guide en effet, le risque s’envisageait suivant la vision de la mesure et de son incertitude présentée en Figure 1.

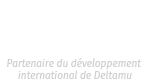

Figure 1 : Vision traditionnelle de la mesure et de son incertitude

Or, cette représentation n’est pas conforme à la réalité. En effet, qu’est-ce qui nous permet de penser, à part la facilité, que la valeur mesurée est systématiquement la valeur la plus probable, tel que le suggère la Figure 1 ?

En se permettant une définition de l’incertitude de mesure plus univoque à nos yeux que celle du VIM, on envisage la réalité sous un angle différent, angle choisi finalement par le JCGM N°106.

Incertitude de mesure : Loi de probabilité des erreurs de mesure

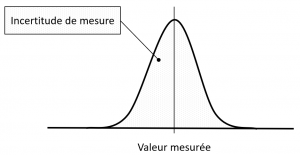

La conséquence de ce changement fondamental qui peut se vivre comme une quasi-révolution copernicienne pour les métrologues se résume dans la Figure 2.

Figure 2 : Vision réaliste d’un résultat de mesure

Pour passer de la Figure 1 à la Figure 2, le JCGM N°106 nous engage dans la démarche bayésienne, démarche qui nous impose désormais de considérer ce que nous savons de l’entité à mesurer avant même de faire la mesure. Quel métrologue, en effet, ne s’est jamais fait cette remarque : « Cette mesure est bizarre ! ». Le fait qu’il puisse détecter qu’une mesure est bizarre suppose qu’il a une connaissance a priori du mesurande. Et c’est cette connaissance a priori que le document JCGM N°106 se propose de prendre en compte pour calculer les risques. Nous pouvons d’ailleurs bien tous nous accorder sur une réalité : le risque Client n’existe que s’il existe des entités réellement non conformes. On peut en effet mesurer « comme un cochon » une entité conforme, elle restera conforme ! Notre connaissance de cette entité, en revanche, est sujette à caution, mais pas l’entité elle-même !

Le rôle des organismes accréditeurs

La dynamique « ISO 9000 » a fini par faire émerger la norme ISO 17025 et les organismes accréditeurs, le COFRAC en France et Accredia en Italie par exemple. Ces organismes ont pour missions de vérifier l’organisation Qualité des laboratoires prestataires en matière de mesures et d‘étalonnages. Ils valident également le réalisme des incertitudes de mesure que les laboratoires revendiquent. Cette mission s’accomplie depuis plus de 20 ans, chacun s’y est habitué, elle est entrée dans les mœurs. Mais, si les experts de ces organismes ont la compétence pour évaluer la pertinence d’un calcul d’incertitude, qu’en sera-t-il demain lorsqu’il s’agira de valider la compétence dans l’évaluation des risques liés aux décisions dans le cadre des vérifications. Autrement dit, comment les organismes d’accréditation pourront valider la pertinence du calcul des risques, sachant qu’il faut désormais prendre en considération l’a priori ?

Il n’y a aucun doute que l’a priori, dans le contexte industriel, doit faire partie des connaissances de l’industriel lui-même et ne peut pas être fourni par un organisme externe. Qu’il fabrique des produits alimentaires, des vis ou des composants électroniques, le producteur devra s’attacher, par exemple via la MSP (Maitrise statistique des Procédés), à quantifier ce qu’il sait réellement produire, c’est-à-dire son aptitude à réaliser telle ou telle caractéristique.

Le risque dans les laboratoires d’étalonnage

Pour les laboratoires d’étalonnage en revanche, la question est différente et plus complexe. En effet, ils reçoivent, par le fruit du hasard, tel ou tel instrument de tel ou tel client, instruments qui, par ailleurs, ont été fabriqués par tel ou tel fabricant. Lesdits instruments ont en plus eu « leur propre vie ». Ils sont donc, en un temps donné, ce qu’ils sont du fait de leur propre fabrication et de leur propre évolution. Or, la fabrication ou l’évolution sont deux paramètres totalement indépendants du laboratoire qui les étalonne ! Aussi, il n’est pas incohérent de penser que quelle que soit la vie de chaque instrument d’un même type, la distribution des vies observées (via les étalonnages), dans chaque laboratoire, devrait être statistiquement identique d’un laboratoire à l’autre (dans le cas général).

Par ailleurs, il est important de rappeler que ce que chaque laboratoire observe n’est pas la réalité des instruments mais « la réalité + les erreurs de mesure (incertitude d’étalonnage) », erreurs de mesure qu’il a lui-même générées à chaque mesure au cours de tous les étalonnages qu’il a réalisés. Cette simple observation induit qu’il est important de ne pas se limiter aux observations, mais qu’il faut aussi chercher la réalité qui se cache sous les observations, pour définir l’a priori (sauf à démontrer que les incertitudes d’étalonnage sont négligeables devant les lois de probabilité a priori).

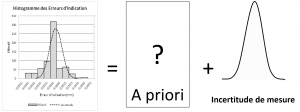

En mathématique il est toujours possible, en théorie, de démêler l’a priori sachant les observations et les incertitudes d’étalonnage en effectuant une déconvolution. Cette opération est résumée graphiquement dans les Figure 3 et Figure 4.

Figure 3: Distribution des erreurs d’indication de pieds à coulisse dans un laboratoire d’étalonnage

Figure 4 : Déconvolution des « observations » (erreurs d’indication) et des erreurs de mesure

Dans l’hypothèse où les observations et l’incertitude d’étalonnage se distribuent selon des lois de probabilité normale, ou gaussienne, la déconvolution est une opération très simple. La moyenne de loi a priori est obtenue par différence entre la moyenne des observations et la moyenne de l’incertitude d’étalonnage (i.e le biais, s’il n’est pas corrigé par le laboratoire). La variance de l’a priori, quant à elle, est obtenue par différence entre la variance des observations et la variance de l’incertitude d’étalonnage (i.e l’incertitude-type au carré).

Par contre, si l’hypothèse de normalité des lois de probabilité n’est pas satisfaite, comme dans plusieurs cas en pratique, cette déconvolution peut poser des problèmes mathématiques non triviaux et pourrait donner des résultat pas fiables …

Vers une base partagée des a priori

Puisque les laboratoires d’étalonnage ont la chance de partager un problème commun (Statuer sur la conformité des instruments de mesure) et puisque les instruments sont ce qu’ils sont indépendamment des laboratoires qui les étalonnent, puis qui les jugent, il est possible de construire et de partager la connaissance a priori desdits instruments. Cette information, une fois validée, pourrait être partagée, via le cloud, à tous les laboratoires soucieux d’appliquer objectivement la nouvelle norme induite par le JCGM N°106. Et puisque les instruments sont ce qu’ils sont partout où ils sont dans le monde, cette information pourrait être partagée à grande échelle, de l’échelle nationale à l’échelle internationale, suivant l’organisation qui serait mise en place. Tout comme les organismes d’accréditation se sont attachés à garantir le réalisme des incertitudes d’étalonnage, il faudra prochainement qu’ils puissent s’engager sur la pertinence des risques associés aux décisions contenus dans les constats de vérification. Une telle base contribuerait largement à cet objectif !

Afin de garantir la totale indépendance de quelconques intérêts économiques particuliers des informations mises à disposition, cette « base des a priori des instruments de mesure usuels » devrait être hébergée par un organisme dont la notoriété et l’indépendance sont des qualités reconnues par tous. Il existe différents organismes, français, européens voire mondiaux, susceptibles de pouvoir faire ce travail en respectant cette exigence de neutralité. Pour construire cette connaissance a priori des instruments de mesure usuels, il conviendrait de réunir un groupe d’experts, en métrologie (pour chaque domaine) et en statistiques. L’objectif serait de recueillir les données d’étalonnage historiques des laboratoires qui souhaiteraient bénéficier de l’accès à l’information des « a priori partagés » et, à partir des incertitudes d’étalonnage qui ont été validées par leur organisme d’accréditation, réaliser la déconvolution nécessaire pour obtenir la connaissance a priori par type d’instruments. Cette commission assurerait évidemment la cohérence des résultats obtenus afin de les mettre à disposition, via une base de données partagées (Open data ou Shared data), à tous les laboratoires accrédités qui souhaitent réaliser des vérifications en suivant les préconisations de la norme ISO/IEC Guide 98-4.

Perspective

Au-delà des vérifications, cette norme nous propose d’utiliser toutes les informations disponibles (a priori, mesure, incertitude de mesure) pour déterminer, en suivant le théorème de Bayes, la loi a posteriori. La valeur moyenne de cette loi a posteriori est en principe plus fiable que la seule valeur mesurée, si toutes les informations utilisées ont été correctement validées. A l’heure des Big Data et des algorithmes qui les traitent, algorithmes qui ont besoin de données fiables pour produire des résultats pertinents, ce post-traitement bayésien des mesures est probablement une voie nouvelle pour les métrologues, surtout dans l’industrie où l’approche bayésienne n’est pas trop pratiquée.

Et comme la « métrologie » telle qu’elle est perçue aujourd’hui par une majorité a commencé dans les laboratoires prestataires, celle de demain, grâce à une application de ces nouveaux concepts dans ces mêmes laboratoires, pourrait également naître chez eux, pour peu qu’on les aide, voire qu’on les force, un peu …