Évaluer la performance des moyens climatiques…

Le suivi périodique des moyens climatiques (enceintes climatiques, réfrigérateurs, congélateurs, …) est un enjeu important, notamment depuis que les laboratoires d’analyses en biologie médicale (L.A.B.M.) sont soumis à la norme NF EN ISO 15189.

Il est utile de rappeler que les normes, si elles sont censées aider les personnes concernées par les problématiques qu’elles abordent, ne doivent pas les empêcher de réfléchir à leur cas particulier. En effet, les normes n’ont pas pour « prétention » de répondre à tous les cas de figure. Elles sont le fruit d’un consensus entre différents acteurs qui ont choisi de réfléchir ensemble à une question, chacun ayant son point de vue et ses contraintes. Il est bien évident que d’autres personnes auraient pu avoir d’autres points de vue et la norme aurait pu s’en trouver modifiée, parfois profondément.

De ce fait, et dans le cas où elle n’est pas formellement imposée (par un client, une réglementation ou tout autre type d’engagement), elle peut être jugée non adaptée pour un contexte donné et, par conséquent, modifiée, voire tout simplement écartée. Il suffit pour cela de maitriser les raisons qui ont poussé à s’écarter du chemin normalisé et personne ne pourra le reprocher, si lesdites raisons sont fondées et documentées.

Pour ce qui est des moyens climatiques, il est intéressant de comparer les approches proposées par le fascicule FD X 15-140 (Mesure de l’humidité de l’air – Enceintes climatiques et thermostatiques – Caractérisation et vérification) et les normes NF EN 60068-3 (Essais d’environnement, notamment les parties 5, 6 et 11). Ces deux normes sont en « concurrence » et largement utilisées mais il est possible, assez facilement, d’en montrer les limites…

Ces normes préconisent un nombre de capteurs et leurs positionnements dans les « enceintes », elles sont identiques sur ce point. Les différences s’expriment dans le traitement des valeurs mesurées lors des mesures.

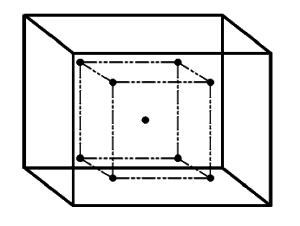

Dans le fascicule FD X 15-140, les mesures réalisées sur 9 points (voir figure ci-dessus) ou 15 points suivant le volume, une fois la stabilisation atteinte (à la température de consigne), vont servir à définir une température moyenne (la moyenne des toutes les mesures, indépendamment de la position des capteurs) et une homogénéité (écart entre le maximum et le minimum sur l’ensemble des valeurs moyennes obtenues avec chaque capteur). Cette façon de déterminer une caractéristique fondamentale de l’enceinte (Quelle est la variation de température à l’intérieur de l’enceinte ?) révèle une croyance : les extremums de température se trouveraient en périphérie du volume ! Cette croyance est évidemment acceptable eu égard à la physique (l’air chaud est moins dense que l’air froid). Elle ne relève pas d’un arbitraire infondé. Néanmoins, quelle garantie peut-on avoir en cette vision, sachant que tous les moyens thermiques ne sont, ni régulés, ni ventilés de la même façon et que la charge dans l’enceinte doit probablement influencer la circulation de l’air ?

Cette recherche du minimum et du maximum est une quête constante pour les métrologues, mais aussi plus généralement, pour les industriels. Le problème est qu’elle est très « déterministe ». L’enceinte compte une infinité de points et comment peut-on croire qu’on aura la chance, à chaque fois, de tomber sur les extremums, en ne relevant que quelques-uns des points possibles. Le métrologue averti fera remarquer qu’il en est ainsi pour la presque totalité des étalonnages et des vérifications (i.e. retenir l’écart maximal observé)… C’est un fait mais est-ce pour autant une approche raisonnable ?

Cette propension à s’intéresser au minimum et au maximum trouve probablement ses racines dans les bulletins scolaires qui ont émaillé notre jeunesse, et émaillent encore celle de nos enfants. La maitresse (ou le maitre) donne chaque trimestre une moyenne, un note minimale et une note maximale de la classe, pour chaque matière.

Chacun pourra reconnaître et comprendre la différence entre le bulletin de notes et les températures dans l’enceinte. La maitresse connaît toutes les notes de la classe, elle peut aisément identifier la plus petite et la plus grande. Le métrologue, quant à lui, ne connaît que quelques points, pris au hasard (mais pas vraiment dans le cas de l’enceinte s’il suit la norme qui les lui impose !).

Chacun pourra reconnaître et comprendre la différence entre le bulletin de notes et les températures dans l’enceinte. La maitresse connaît toutes les notes de la classe, elle peut aisément identifier la plus petite et la plus grande. Le métrologue, quant à lui, ne connaît que quelques points, pris au hasard (mais pas vraiment dans le cas de l’enceinte s’il suit la norme qui les lui impose !).

C’est à cette question que les statisticiens ont répondu par l’inférence statistique, c’est-à-dire la science qui vise à estimer les propriétés d’une population parente (tous les points de l’enceinte) à partir de l’un de ses échantillons (les 9, 15 ou tout autre nombre de points). Voilà typiquement le rôle dévolu à l’écart type qui, s’il est calculé à partir d’un échantillon d’une population parente de loi de probabilité connue, permet d’envisager les valeurs non observées dans l’échantillon… Dans le cas où la population parente est gaussienne, on sait que 95% environ des valeurs de la population « tiennent » dans l’intervalle « moyenne ± 2σ ». Si la loi de probabilité de la population parente n’est pas gaussienne en revanche, cette proportion de 95% n’a plus de sens. Les propriétés de l’écart type, même s’il se calcule toujours de la même façon (i.e. indépendamment de la loi parente) dépendent de la loi parente (qu’il faut donc chercher à connaître).

Ainsi, et même en mettant la plus grande volonté du monde, il est très peu probable que l’homogénéité telle que calculée dans le fascicule FD X 15-140 (différence en θMax et θMin) ait le moindre rapport avec ce qui se passe « en vrai » dans le volume. Tout calcul de risque de non conformité à une exigence établie sur cette homogénéité n’est alors que calcul et ne peut pas quantifier sincèrement la réalité…

Les normes EN, en revanche, ne traitent pas de l’homogénéité (même si elle l’évoque évidemment) mais calculent, en revanche, une incertitude sur la température moyenne qui intègre la dispersion entre les mesures réalisées avec les capteurs (reproductibilité inter-capteurs). On note donc ici la volonté d’aller chercher les valeurs non observées en utilisant un outil de base (σ) de l’inférence statistique. En revanche, l’utilisation de l’écart type dans cette stratégie est parfaitement critiquable. En effet, l’estimation de l’écart type repose sur un principe simple : l’échantillon doit être aléatoire et représentatif. Or, si on suit le raisonnement de la FD X 15-140 (choisir les points en tentant de trouver les extremums), on ne respecte pas du tout cette condition. C’est un peu comme si, pour chercher l’écart type d’un phénomène aléatoire composé de 5 dés (somme des faces obtenues à chaque lancer), on ne retenait que les valeurs proches de 5 et les autres proches de 30. L’écart type ainsi calculé perdrait toutes ses propriétés d’estimation de la dispersion réelle du phénomène ! De plus, en se bornant à observer les valeurs de température en périphérie du volume utile, on ne peut donner aucune information sur la dispersion des températures dans le volume, puisqu’on ne le regarde pas (alors que c’est bien là que se trouvent les entités qui nécessitent d’être portées à une température donnée, pour conservation ou sollicitation). Or, l’écart type, comme rappelé ci-dessus, n’a de propriété que si on connaît la loi de probabilité parente et ici (comme dans la FD X 15-140), on ne cherche même pas à la connaître…

Le lecteur aura compris les limites de ces deux référentiels alors qu’ils imposent de disposer de moyens conséquents : au moins 9 capteurs (et leurs étalonnages respectifs), une centrale d’acquisition, un logiciel dédié (pour tous les calculs) sans compter, à chaque qualification, l’immobilisation du moyen le temps des mesures. Or, et notamment dans le cas des systèmes climatiques qui restent en permanence à une température donnée (réfrigérateurs, congélateurs, …), ne serait-il pas plus pertinent (efficient) de mesurer avec le même capteur déposé aléatoirement (comme le veulent les statistiques) dans le volume en charge (i.e. en le déplaçant entre chaque mesure), en des temps différents (le même jour, ou sur des jours différents) et de traiter statistiquement les données pour s’assurer qu’il n’y a de dérive, ni de la moyenne, ni de la dispersion ? En somme, exploiter les données de la surveillance quotidienne, en changeant la position, pour apprendre ce qu’il en est réellement du volume climatique…

Si on comprend aisément le besoin de valider de la sorte des enceintes climatiques destinées à des essais (ces normes ont été écrites dans cet esprit, mais on pourrait manifestement faire mieux) car elles peuvent être utilisées à des températures de consignes différentes à chaque fois, il est plus contestable de se limiter à ces techniques pour des moyens déjà suivis quotidiennement.

J’ai récemment présenté une conférence (co-écrite avec Laurent Leblond et Christophe Dubois) sur le sujet du traitement des données de mesure dans le cadre des phénomènes d’intérêts observés par échantillonnage. En voulant pousser la réflexion à son maximum, on se rend compte que de nombreuses questions restent à aborder mais nous ne désespérons pas de les résoudre. Vous pouvez voir et télécharger la conférence.

Pour conclure, chacun comprendra que les normes ne sont que des guides (elles ne prétendent d’ailleurs pas être autre chose) qu’il convient de suivre ou d’adapter, suivant les situations. Il est parfois plus efficace de s’interroger sur son propre cas plutôt que de se laisser porter par des habitudes qui, parfois, ne correspondent pas du tout au besoin…