2019

| Pourquoi la Smart Metrology n’est plus une option ! |  |

Nous venons d’un monde où les incertitudes de mesure n’existent pas ! En effet, depuis 1837, la Métrologie Légale, par son action dans le cadre des échanges commerciaux, a instauré une confiance totale dans les résultats de mesure qui servent à établir le prix d’une transaction. Alors qu’à la veille de la Révolution Française, nos anciens exigeaient, au sens propre, « un poids et une mesure », la mesure semble juste aux yeux de tous aujourd’hui.

Chacun de nous entend et utilise quotidiennement des résultats de mesure sans se soucier de l’inévitable incertitude associée. Cela ne pose aucun problème pour les échanges commerciaux mais cela ne pose a priori aucun problème non plus dans le monde industriel. S’il est aisé de comprendre que les incertitudes de mesure peuvent être négligées pour les mesures commerciales, il est plus surprenant de constater ceci lorsqu’elles engagent des décisions industrielles.

Dans le cas des échanges commerciaux, l’erreur de mesure peut jouer pour ou contre l’acheteur (symétriquement pour ou contre le vendeur). On peut avoir un peu plus, ou un peu moins, d’essence dans son réservoir ou de tomates dans son panier, rien de très grave tant que l’écart entre la réalité et la mesure est raisonnable… il n’y a pas mort d’homme !

Dans les décisions industrielles en revanche, les enjeux peuvent être très différents. L’erreur de mesure n’a, là encore, pas de préférence. Elle peut laisser croire qu’une entité est conforme alors qu’elle ne l’est pas en réalité (risque client) ou alors, symétriquement, qu’une entité déclarée non conforme est conforme en réalité (risque fournisseur). Imaginez un instant que ce soit vous qui soyez personnellement concerné, par exemple dans le cas d’un examen de biologie médicale. L’erreur de mesure peut laisser penser que vous n’êtes pas malade alors que vous l’êtes en réalité. Vous ne bénéficierez donc pas du traitement qui aurait pu arranger votre situation, voire vous sauvez la vie. Il en est de même pour une pièce critique d’un moteur d’avion qui peut être vue conforme alors qu’elle ne l’est pas … et vous êtes dans l’avion ! Contrairement aux échanges commerciaux, il peut y avoir des décisions industrielles qui conduisent à « mort d’homme » ! Cette situation permet de bien saisir la signification de l’expression « risque client ».

Pour le « risque fournisseur », et même si le concept est séduisant puisqu’il induit une notion de « partage des risques », les choses sont plus subtiles. En nous replaçant dans l’exemple de la biologie médicale, le « risque fournisseur » reviendrait à déclarer malade un patient non malade en réalité. Ce dernier, parfaitement sain, pourrait donc se voir infliger, du fait d’une erreur de mesure, une cure de chimiothérapie parfaitement inutile. Peut-on réellement parler de « risque fournisseur » lorsque c’est le patient (c.-à-d. le client) qui le subit. D’ailleurs, n’est-ce pas la même chose dans tous les autres cas ? Lorsqu’on déclare à tort un instrument non conforme suite à une opération de vérification, est-ce vraiment le fournisseur (c.-à-d. le laboratoire qui a déclaré la non-conformité) ou le client qui subit réellement les conséquences de cette erreur ? Tous ceux qui ont eu à gérer une étude d’impact ou à remplacer en urgence un instrument réputé non conforme savent que c’est eux qui ont payé, parfois au prix fort, cette erreur de jugement et non leur fournisseur.

De plus, on démontre que ces deux risques n’évoluent pas de façon symétrique : gagner 1% sur l’un d’eux peut faire perdre 10% ou plus sur l’autre. Quand on a compris que les deux risques étaient supportés par le client final, on peut s’interroger sur la stratégie qui règne actuellement, à savoir minimiser le « risque client » le plus possible. Cette stratégie conduit à une explosion du « risque fournisseur » assumé par le client final. Ne peut-on pas faire mieux ? La Smart Metrology a-t-elle un rôle à jouer dans cette nécessaire « optimisation des risques » ? A une époque où on prend enfin conscience que les ressources ne sont pas infinies et que la compétition est devenue internationale, n’est-il pas temps de changer nos pratiques pour tendre enfin vers le « juste nécessaire » ?

De l’apparente inutilité des incertitudes de mesure …

En ligne avec les pratiques « ISO 9001 », la norme NF EN ISO 14253-1 a eu pour objectif de résoudre la question de la prise en compte des incertitudes de mesure, question dont la réponse conditionne l’enjeu de « qualité » de nos productions : comment s’assurer que les caractéristiques ou « entités » produites sont conformes à leurs spécifications ?

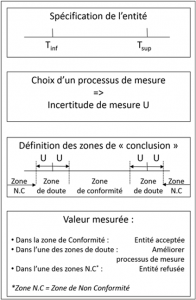

La norme propose d’appliquer la stratégie résumée en figure 1

Figure 1 – Prise en compte des incertitudes de mesure suivant norme ISO 14253-1

Suivant cette norme, il s’agit simplement de « soustraire » aux bornes de la tolérance l’incertitude de mesure U pour définir une zone, dite « Zone de conformité », qui assure de déclarer « conforme » toute entité dont la valeur mesurée appartiendra à ladite zone. Autour des bornes Tinf et Tsup, dans un intervalle de largeur ± U, la norme définit deux zones de doute et préconise, afin de statuer, de mesurer à nouveau l’entité à l’aide d’un processus de mesure exprimant une incertitude plus petite. Enfin, une valeur mesurée au-delà des zones précédentes conduit à déclarer la non-conformité de l’entité.

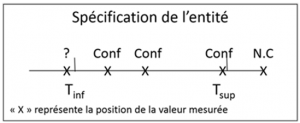

Au quotidien, la déclaration de conformité suit plutôt l’approche décrite en figure 2

Figure 2 – Pratique constatée

Puisque l’incertitude de mesure n’est généralement pas considérée dans la pratique courante, sans pour autant générer de catastrophes a priori, nous pouvons en déduire, sans trop nous avancer, que les tolérances exprimées ont d’ores et déjà les propriétés de la « zone de conformité » décrite dans la norme NF EN ISO 14253-1. Ce constat n’est finalement pas surprenant. Les tolérances actuelles ont été déterminées en réalisant des entités conformes fonctionnellement, de manière itérative en phase de mise au point à partir de valeurs mesurées considérées comme « seules juge de paix ». Sous cet angle, prendre en compte l’incertitude de mesure se présente comme une fabuleuse opportunité pour tendre vers une expression plus rationnelle du besoin fonctionnel. Aussi, pour ceux qui sauront remettre en cause cette croyance en des mesures justes, un potentiel non négligeable d’amélioration de la productivité industrielle s’ouvre. En effet, des spécifications plus larges, « au juste nécessaire », permettent d’envisager non seulement des coûts de production plus faibles mais également une meilleure gestion des consommations, tant en énergie qu’en matières premières, nécessaire pour espérer un futur plus « durable ».

Dans le livre blanc « Objectif Smart Tolerancing » téléchargeable gratuitement, les pratiques en termes d’allocation de tolérance sont décryptées et des propositions d’évolution sont exposées. Actuellement, la pratique très largement majoritaire est dite au « Pire des Cas ». Elle est coûteuse car elle ne tient pas compte des effets aléatoires qui affectent toutes les productions. Elle impose de considérer que le pire des bouchons doit s’assembler avec le pire des stylos alors qu’il serait plus efficient d’assurer un taux acceptable de couples « Bouchon / Stylo » fonctionnels. Cette pratique du « pire des cas » est tellement exigeante qu’on peut se passer de prendre en compte les incertitudes de mesure. Elles sont comprises, en quelque sorte, dans la sécurité qui entoure cette façon de faire, mais, le plus souvent, sans vraiment être maîtrisée.

Un véritable potentiel existe donc pour peu qu’on veuille bien remettre en cause sa façon de penser. D’autres approches matures permettent d’optimiser l’allocation de tolérance, donc d’optimiser les coûts de production. Pour cela, il faut être capable de « modifier son logiciel » et là n’est pas la moindre des difficultés. D’ailleurs, en conclusion, ce livre blanc souligne : « ces méthodes, tolérancement inertiel ou « Process Tolerancing », ont fait leurs preuves. Elles ne demandent qu’à être déployées à plus grande échelle dans le souci d’améliorer la compétitivité des entreprises industrielles. Leur utilisation ne dépend pas d’investissements lourds et hasardeux, ni d’outils informatiques compliqués à implémenter. Le frein à leur utilisation est largement identifié : la résistance au changement justifiée par le trop classique « on a toujours fait comme ça, changer est trop risqué ! » et demande un certain courage managérial pourrait-on ajouter !

Les incertitudes de mesure ne concernent pas que les commerçants ou les industriels. Dans le monde de la recherche, elles ont aussi potentiellement un impact dont il est impératif de se prémunir. Nous évoquons ce domaine avec Laurent Leblond dans le livre « Smart Metrology, de la métrologie des instruments à la métrologie des décisions » en citant Georges Charpak, prix Nobel de Physique :

Dans son livre « Devenez sorciers, devenez savants », dont Henri Broch est co-auteur, Georges Charpak écrit : « … Or, il faut rappeler que l’incertitude sur une donnée est toute aussi importante que la donnée elle-même puisqu’elle décide de la fiabilité que l’on peut accorder à cette dernière et, par voie de conséquence, de la fiabilité à accorder à la théorie reposant sur ce résultat …». En interpellant ainsi ses pairs, Georges Charpak souligne que cette question de la fiabilité de la donnée n’est pas forcément toujours au cœur des préoccupations des chercheurs.

Dès lors, espérons que Max Planck se trompe quand il écrit : « une théorie nouvelle ne triomphe jamais, ce sont ses adversaires qui finissent par mourir. ». Le potentiel existe, c’est certain, mais ce chemin, pour mettre en œuvre ce changement pourtant salvateur est probablement encore très (trop ?) long …

L’Intelligence Artificielle : une disruption qui change le monde

Le monde dans lequel nous vivons est un monde que les anglo-saxons qualifient, à juste titre nous semble-t-il, de « conduite par l’opinion » (« opinion driven »). C’est cette façon de penser qui conduit à exiger, pour reprendre l’exemple des stylos évoqué ci-avant, que le pire des bouchons doit pouvoir s’associer avec le pire des stylos. Il s’agit d’une croyance sur laquelle s’appuient notre raisonnement, nos exigences et nos pratiques.

De façon similaire, un plan d’expérience cherchant à modéliser le comportement d’un phénomène par rapport à des facteurs d’entrée relève de l’opinion. L’expérimentateur pense (croit ?) que son phénomène d’intérêt est influencé par tel et tel facteur et il construit alors son expérience sur cette croyance. Cependant, rien ne garantit qu’il n’ait pas oublié un, voire plusieurs, paramètre(s) influent(s). Le cas échéant, le modèle n’exprimera pas la réalité. Combien de situations dysfonctionnelles ont pour origines des croyances incomplètes ? Personne ne peut probablement répondre à cette question mais tous les industriels, en revanche, sont confrontés à des problèmes qu’ils ne savent pas résoudre. Ces situations existent sans aucun doute !

Le Big Data, les capacités de stockage de données, le cloud et la puissance de calculs des ordinateurs ont ouvert de nouvelles possibilités. L’Intelligence Artificielle, qui se traduit par de nombreux algorithmes de calculs, permet d’avoir une approche toute différente. On parle parfois de techniques naïves, ou agnostiques. Ces algorithmes qui reposent sur les faits (« fact driven ») n’imposent pas d’autres hypothèses que de disposer de données et cette seule exigence est une véritable opportunité pour la métrologie. En effet, ces données ne donnent une juste représentation de la réalité que si les mesures sont fiables. Ces données ne servent pas uniquement à statuer sur une action (conformité, réglage, …) mais elles représentent également un capital qui s’accumule au fil du temps afin d’être exploité par l’entreprise pour comprendre et agir.

Fiabiliser les résultats de mesure, un impératif catégorique.

En Juillet 2017, la revue Science & Vie titrait « Une nouvelle intelligence est née ». Un dossier complet était consacré à l’Intelligence Artificielle et la puissance de ses algorithmes. Dans ce dossier, un exemple nous explique qu’un algorithme a appris à « reconnaître » la présence d’un lion sur une photo (rappelons que vue d’un ordinateur, une image n’est qu’une immense collection de pixels !), non pas via la couleur de l’animal ou la forme de sa crinière, ce qui serait déterminant pour un humain, mais à partir d’une particularité de ses yeux. L’algorithme a su découvrir cette « signature » en exploitant une bibliothèque de photos dans laquelle certaines comportaient des lions, d’autres non.

Cet exemple est particulièrement intéressant à double titre. Il montre bien, d’une part, la capacité des algorithmes à trouver des éléments différenciants qui ne nous apparaissent pas naturellement. Combien de tels « signaux faibles » se cachent encore dans les procédés industriels de production et posent des problèmes en impactant négativement la performance des entreprises à cause de rebuts ou de durées de vie altérées ? D’autre part, il met en évidence un besoin de mesures bien plus fiables qu’actuellement : si la photo est floue, comment « voir » les yeux ?

Le Big Data et l’Intelligence Artificielle permettront de mieux maîtriser des phénomènes compliqués à appréhender avec nos outils traditionnels. Ces nouveaux outils ont cependant de nouvelles exigences dont la fiabilité des données n’est pas la moindre. Le métrologue, devenu smart, a donc un rôle essentiel à jouer dans ce nouveau monde qui n’attendra pas une mutation progressive. Il ne s’agit pas de passer du « pire des cas » au tolérancement statistique. Il s’agit d’une véritable disruption dans la façon de penser en passant d’une « conduite par l’opinion » à une « conduite par les faits ».

Les pionniers du Big Data résumaient le Big Data à trois caractéristiques, les 3 V pour Volume, Variété et Vélocité. Ils n’ont surement pas mis longtemps à admettre qu’il en fallait un 4ème pour que leurs algorithmes fonctionnent : la Véracité !

Puisque les algorithmes sont agnostiques, ils ne peuvent que « croire ce qu’on leur raconte » … Ils peuvent aller chercher des signaux faibles dans une multitude d’informations mais ils sont bien incapables, et ce n’est pas leur rôle, de corriger les données dont ils disposent. L’adage « Garbage in, garbage out » prend ici tout son sens. Si on met n’importe quoi en entrée, on obtient n’importe quoi en sortie. Le métrologue qui, jusque-là, s’est surtout occupé à gérer des instruments de mesure doit relever le défi des mesures fiables, ce qui lui imposent un nouveau rôle : être le garant de la véracité des données mesurées de son entreprise.

Inférence bayésienne : une révolution copernicienne de la Métrologie

Alors que les incertitudes de mesure devraient être au cœur des préoccupations des métrologues, il faut bien admettre que nous en faisons bien peu cas en pratique. Alors, à quoi cela peut-il bien servir de les calculer, si ce n’est pas pour les utiliser ?

Pour utiliser ces incertitudes, la norme NF ISO/IEC Guide 98-4* ouvre un champ fort utile en métrologie : l’approche bayésienne. La notion d’a priori employée dans cette approche pour estimer les risques liés à la déclaration de conformité peut également avoir bien d’autres applications.

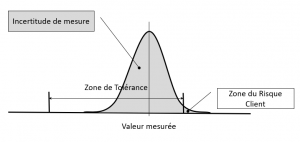

Le risque de déclarer « conforme » une entité en réalité « non conforme » se résumait, dans la vision classique, à la surface qui dépasse de la zone de tolérance (cf Figure 3)

Figure 3 : Vision traditionnelle de la valeur mesurée, de l’incertitude associée et du risque client

Or, cette vision est manifestement incomplète. En effet, le risque client n’existe que si l’entité est réellement non conforme. Il est donc évident qu’il faut également considérer la probabilité que l’entité soit non conforme dans le calcul du risque. Ce dernier est en fait la réalisation simultanée de deux événements : mesurer conforme (de probabilité P1) une entité en réalité non conforme (de probabilité P2).

La probabilité P1 peut être calculer à partir de l’incertitude de mesure. La probabilité P2 se calcule, quant à elle, à partir d’une connaissance a priori sur la production de l’entité. Cette approche, mêlant observation (mesure) et a priori sur la réalité à mesurer est dite bayésienne. Il s’agit alors d’inférer, à partir de l’ensemble de la connaissance (mesure, incertitude de mesure et a priori), la réalité la plus probable. Un article sur ce blog explique comment utiliser toutes ses informations pour obtenir une valeur plus fiable que la valeur mesurée.

Très schématiquement, il s’agit :

- de considérer l’équation de base du métrologue (Vmesurée = VVraie + emesure),

- d’en déduire qu’il existe une multitude de combinaisons (VVraie, emesure) pour une même valeur mesurée,

- de calculer la probabilité de chacune d’elles (P1xP2) dès lors que nous connaissons l’a priori et l’incertitude de mesure,

- de trouver la combinaison la plus probable et d’en déduire la valeur vraie la plus probable qui se cache derrière la valeur mesurée.

Ce post-traitement de la valeur mesurée impose de connaitre l’a priori des procédés de l’entreprise et l’incertitude de mesure. C’est une façon originale d’utiliser l’incertitude de mesure, dans un objectif de performance. Le smart métrologue devra s’en saisir. La compétence de ce futur métrologue consistant à évaluer les risques et les valeurs les plus probables sera bien plus valorisante et essentielle pour son entreprise que la gestion des étalonnages périodiques, souvent inutiles et essentiellement réalisés pour contenter les audits.

La surveillance dynamique : la fin des étalonnages périodiques inutiles

La stratégie historique des « étalonnages périodiques calendaires » ne permet pas de garantir la fiabilité des mesures. Cette pratique ne détecte en effet les problèmes qu’a posteriori alors qu’il faut les détecter dynamiquement. Dans une logique de maîtrise des risques, il est impératif de savoir à partir de quand les données ne sont plus fiables, parce que perdre la connaissance de procédés faute de fiabilité des données, c’est s’exposer à payer le prix fort face à des concurrents plus agiles.

Pour sortir des étalonnages périodiques, l’information a priori est aussi fort utile. Lorsqu’on sait à l’avance ce que l’on est censé trouver, on peut en permanence s’assurer que les résultats sont cohérents avec cet a priori. Si cette cohérence est mise en doute, cela signifie, soit que le procédé change (information capitale pour la satisfaction client), soit que le processus de mesure évolue (information capitale pour savoir s’il faut ou non l’étalonner). Les statistiques proposent de multiples tests pour savoir si un échantillon (les mesures du jour, de la semaine, de l’heure suivant les fréquences d’échantillonnage) appartient ou non, avec un niveau de confiance donné, à une population parente connue (a priori). Ces tests sont ce qu’il faut au métrologue pour détecter, quasiment dès qu’elle se produit, une anomalie sur un instrument de mesure. Il peut alors prendre les dispositions qui s’imposent.

L’a priori est donc une information indispensable à la maîtrise des risques et sa connaissance permet de détecter « en live » les anomalies. De ce fait, il devient possible de sortir du monde des étalonnages/vérifications à l’aveugle pour entrer dans celui des périodicités conditionnelles.

Conclusion

Tous les métrologues savent que les mesures sont fausses mais ils doivent savoir, et faire savoir également, que la plupart des tolérances sont fausses, c’est-à-dire sans réel rapport avec le besoin fonctionnel. Ce monde « d’erreurs » s’en sort au détriment de l’économie et du développement durable. Cette « sur-exigence » induit des conséquences néfastes sur notre organisation industrielle actuelle et future.

Tous nos schémas de pensées sont issus d’une époque où le monde était pensé sans limite et où le principe « qui peut le plus peut le moins » régnait en maître. Depuis, les frontières se sont ouvertes, la concurrence est devenue mondiale et une conscience écologique s’est peu à peu installée : faire « trop », c’est faire « trop cher » économiquement et « trop impactant » pour nos ressources communes.

Il est désormais plus que temps d’écouter la sagesse des plus anciens : « Treat the earth well : it was not given to you by your parents, it was loaned to you by your children ». Ce principe, repris plus tard par Antoine de Saint Exupéry, nous invite simplement à considérer les générations futures dans nos choix et nos pratiques. L’évolution technologique que représente aujourd’hui le Big Data impose une métrologie rénovée : la Smart Metrology. Cette dernière peut concourir à la rationalisation de nos stratégies et de nos décisions pour tendre vers le « juste nécessaire ». La situation étant critique, la Smart Metrology n’est donc effectivement plus une option …

Post scriptum

Un grand merci à mon ami Laurent Leblond pour sa participation active à l’écriture de cet article !

* Incertitude de mesure – Partie 4 : rôle de l’incertitude de mesure dans l’évaluation de la conformité (AFNOR 2013). Voir aussi FD X 07-039 (AFNOR 2018) : Mise en œuvre de la norme NF ISO/IEC Guide 98-4.