2019

| Garbage in, garbage out ! |  |

La fin du XXème siècle a vu la consécration des systèmes Qualité. Dans leurs sillages, la métrologie a connu un essor sans pareil dans l’histoire. Malheureusement, le métrologue est dans un monde où les tolérances spécifiées tiennent déjà compte des incertitudes de mesure. Cette prise en compte s’est souvent faite par itérations et de façon empirique. C’est l’expérience (« ça marche, ça ne marche pas ») qui nous permet de savoir que pour obtenir telle fonction ou telle propriété, il faut mesurer dans tel intervalle, avec tel type de moyen de mesure. Le livre blanc publié l’an passé par le site Manufacturing.fr explique ce phénomène et les spécialistes du domaine proposent des solutions pour mieux définir les tolérances, dans un souci de « juste nécessaire » indispensable à la compétitivité.

Dans un tel contexte, il n’est pas nécessaire de connaitre les incertitudes et cette réalité permet aux étalonneurs de déclarer des conformités sans connaitre l’utilisation réelle des instruments. Lorsque les normes existent, les E.M.T (Erreurs Maximales Tolérées) y sont fixées empiriquement, sur la base de la connaissance « d’experts » qui s’appuient sur leurs expériences de laboratoire. Le métrologue « gère » alors ses vérifications pour s’assurer que ses instruments ne sont pas trop différents des autres instruments de même type, à des dates souvent arbitraires, ce qui semble être satisfaisant pour tout le monde ou presque.

Auditeurs, audités, clients, … La boucle est bouclée sans qu’à aucun moment les vraies questions métrologiques ne soient réellement abordées : incertitudes de mesure, risques induits, détection dynamique des éventuelles dérives, accidentelles ou naturelles. Le métrologue vit en quelque sorte dans un monde parallèle. Il génère ainsi très peu d’interactions avec le cœur de la production (sauf pour récupérer les instruments) mais beaucoup avec les auditeurs et les prestataires d’étalonnage, ce qui ne va pas sans provoquer une certaine déconsidération du métier …

La mesure n’est pas uniquement nécessaire aux opérations de « contrôle ». La mesure est essentielle pour comprendre les procédés de fabrication et pour les piloter dans l’objectif de faire « bon du premier coup ». Le métrologue est rarement impliqué dans ses fonctions à très forte valeur ajoutée pour l’entreprise. Dans les fabrications en séries, les spécialistes des procédés font des plans d’expériences pour définir les paramètres à surveiller (et leurs plages de variation tolérables) dans la phase de mise au point puis de la M.S.P (Maîtrise Statistiques des Procédés) pour le pilotage. Ils font évidemment tout cela avec des instruments de mesure, étalonnés quand l’entreprise est certifiée, mais quid de la qualité réelle des mesures ? Si un instrument « conforme » est une condition nécessaire à une mesure de qualité, elle n’est pas une condition suffisante. Tous les autres facteurs (opérateurs, environnement, …) influent sur les mesures et génèrent des erreurs. Dès lors, les belles théories ne fonctionnent plus : le procédé se met à produire du « non conforme » sans qu’on en comprenne facilement les raisons. Toutes les entreprises subissent des aléas non maîtrisés dans leurs procédés de fabrication. Elles soupçonnent souvent des facteurs extérieurs (les fournisseurs, la nature, le hasard, …) faute de les trouver en interne. Elles « font avec », avec toutes les conséquences négatives que cela suppose.

.

Homo numericus …

Cette époque devrait pourtant être révolue ! L’apport de l’Intelligence Artificielle, d’une approche « Fact Driven » et non « Opinion Driven », permet d’espérer l’amélioration de la maîtrise de certains phénomènes, notamment par la détection de signaux faibles. Si les plans d’expérience ont su modéliser les facteurs principaux qui influencent les procédés, les petits dysfonctionnements qui empoissonnent le quotidien des équipes de production sont potentiellement détectables via des algorithmes. Deux billets sur ce sujet sont à relire : « une nouvelle intelligence est née » et « Big Data, la symphonie des données »

Ces nouvelles technologies sont très opérantes mais elles ont une exigence qui, jusqu’ici, a été contournée comme nous l’avons vu plus haut : la véracité des données ! Deltamu a mis en ligne un site en 2015 pour prévenir les métrologues de l’évolution à venir en publiant, notamment, un livre blanc téléchargeable gratuitement qui montre des cas industriels où les données disponibles relèvent plus du bruit de mesure que de la réalité. Et, malheureusement, les algorithmes ne savent pas faire la part des choses sur ce point : « Garbage in, garbage out ! »

Cette obligation de véracité des données est, depuis toujours, au cœur des préoccupations de Deltamu. Nous voici désormais au cœur de l’actualité et il est temps de reconsidérer les fondamentaux de la métrologie.

Chaque métrologue connait la relation fondamentale de la mesure :

Valeur mesurée = Valeur vraie + Erreur de mesure (1)

Jusqu’alors, l’industrie a pu se contenter d’une information, parfois médiocre, en exigeant des tolérances trop serrées par rapport au besoin fonctionnel réel ! Garantir la véracité des données impose, aujourd’hui, de ne plus se contenter de la valeur mesurée pour prendre des décisions. Il est impératif de concentrer son attention sur l’obtention de la « valeur vraie ».

La statistique est un outil aux ressources fabuleuses. Elle est à la base de l’évaluation des incertitudes de mesure, évaluation dont Deltamu s’est fait une spécialité depuis sa création (plus de 20 ans). Certaines théories séculaires ont même resurgi récemment avec le document JCGM 106, devenu norme internationale (ISO/IEC Guide 98-4), puis norme nationale (NF ISO/IEC Guide 98-4). Ce document introduit une approche dite « bayésienne » dans le traitement des résultats de mesure. Et toutes ses approches pragmatiques donnent lieu désormais à une nouvelle prestation de Deltamu, pour aider les « Data Scientist » à faire « Parler les données »: le B.M.R : « Bayesian Measurement Refinement »

On lit souvent que les données sont le pétrole du XXIème siècle. Cependant, le pétrole, comme les mesures, n’est pas utilisable sans raffinage. Voilà bien le rôle assignable au métrologue du XXIème siècle : Raffiner les mesures, c’est à dire « extraire » la réalité, ce dont les algorithmes ont besoin. Il s’agit donc d’être capable « d’enlever » les erreurs de mesure des mesures disponibles.

Deltamu, en s’appuyant sur les préconisations bayésiennes de la norme NF ISO/IEC Guide 98-4, propose désormais de réaliser, ou de vous aider à réaliser, cet indispensable raffinage …

Il ne s’agit pas ici d’entrer dans les détails du raffinage mais on peut en donner les grandes étapes.

Phase 1 : loi des erreurs de mesures

L’évaluation des incertitudes de mesure, c’est à dire la « loi de distribution des erreurs de mesure » relève d’une compétence particulière. En tenant compte du processus de mesure, et en maîtrisant les outils statistiques qui permettent de modéliser ce qui se passe dans le monde « aléatoire », cette loi de distribution des erreurs de mesure est objectivement quantifiable.

Une fois ce travail réalisé (Phase 1), il « suffit » de considérer l’équation (1) ci-dessus pour écrire :

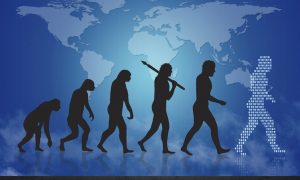

Composition des séries de mesures

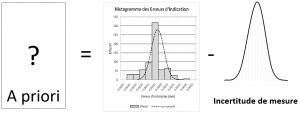

Note : l’histogramme à gauche de la figure ci-dessus représente la distribution des mesures disponibles, l’a priori définit la distribution des valeurs vraies sous-jacentes (réalité recherchée) et la gaussienne, à droite de la figure, représente « l’incertitude de mesure », c’est à dire la loi de distribution des erreurs de mesure qui ont entachées aléatoirement chacune des mesures.

Autrement dit, les mesures disponibles sont « le fruit » du mélange entre la réalité (ce dont ont besoin les algorithmes) et des inévitables (même si on aimerait les oublier) erreurs de mesure.

Une fois admise cette réalité, il suffit de faire un peu de mathématiques ….

Phase 2 : Une déconvolution

La figure précédente permet d’écrire la relation suivante :

Déconvolution des mesures pour obtenir la distribution de la réalité

Cette opération suppose de connaitre l’incertitude de mesure de façon objective, sachant qu’il n’est pas rare que cette dernière soit surévaluée par les métrologues dans l’esprit : « Comme ça, on est sûr ! ». Par ailleurs, cette opération peut s’avérer compliquée quand les phénomènes en présence (« distribution des mesures » et « incertitude de mesure ») ne sont pas gaussiens …

Phase 3 : Inférence bayésienne

L’inférence bayésienne consiste à prendre en considération la totalité des informations disponibles pour statuer sur une mesure. Quand on ne connait rien d’autre que la valeur que donne l’instrument (valeur mesurée), on fait avec … mais si on en connait plus, notamment l’incertitude de mesure du processus qui a produit la mesure (rôle théorique du métrologue) et la distribution des valeurs vraies possibles du mesurande (rôle à saisir par le métrologue devenu Smart), on peut aller beaucoup plus loin que la seule valeur mesurée pour se forger un avis sur la réalité. L’article sous ce lien précise comment il est possible d’exploiter ces informations pour définir la loi « a posteriori », loi dont la moyenne est plus probable que la seule valeur mesurée. C’est bien cette valeur-là, « la plus probable sachant tout ce que je sais », qu’il est préférable de substituer à la valeur mesurée souvent de qualité médiocre …

Cette opération de « raffinage bayésien » s’apparente réellement à l’opération de raffinage du pétrole. Qui aurait l’idée de mettre du pétrole brut dans le réservoir de sa voiture ? Il en va de même avec les mesures dans les algorithmes ! Prises sans précaution, elles risquent, souvent, soit de masquer une réalité pourtant modélisable, soit de faire croire en une pseudo-réalité qui n’est que le fruit du hasard des mesures et qui ne sera pas robuste à l’expérience.

Le métrologue du XXIème siècle n’est pas un gestionnaire de planning ! Il est le « Total » de demain et j’ai la faiblesse de penser qu’il y trouvera beaucoup plus de reconnaissances que lorsqu’il collait, au siècle dernier (;-)), des étiquettes ….